Main Page: Difference between revisions

No edit summary |

|||

| (375 intermediate revisions by the same user not shown) | |||

| Line 1: | Line 1: | ||

[[File:Infocepo-picture.png|thumb|right|Découvrir le cloud et l’IA sur infocepo.com]] | |||

= | = infocepo.com – Cloud, IA & Labs = | ||

= | |||

Bienvenue sur le portail '''infocepo.com'''. | |||

Ce wiki s’adresse aux administrateurs système, ingénieurs cloud, développeurs, étudiants et passionnés qui veulent : | |||

== | * Comprendre les architectures modernes (Kubernetes, OpenStack, bare-metal, HPC…) | ||

* Mettre en place des assistants IA privés et des outils de productivité | |||

* Construire des labs concrets pour apprendre en pratiquant | |||

* Préparer des audits, migrations et automatisations à grande échelle | |||

L’objectif : transformer la théorie en '''scripts, diagrammes et architectures réutilisables'''. | |||

__TOC__ | |||

---- | |||

= Démarrer rapidement = | |||

== Parcours recommandés == | |||

; 1. Monter un assistant IA privé | |||

* Déployer un stack type : '''Open WebUI + Ollama + GPU''' (H100 ou GPU grand public) | |||

* Ajouter un modèle de chat + un modèle de résumé | |||

* Intégrer des données internes (RAG, embeddings) | |||

; 2. Lancer un lab Cloud | |||

* Créer un petit cluster (Kubernetes, OpenStack ou bare-metal) | |||

* Mettre en place un pipeline de déploiement (Helm, Ansible, Terraform…) | |||

* Ajouter un service IA (transcription, résumé, chatbot…) | |||

; 3. Préparer un audit/migration | |||

* Inventorier les serveurs avec '''ServerDiff.sh''' | |||

* Dessiner l’architecture cible (diagrammes cloud) | |||

* Automatiser la migration avec des scripts reproductibles | |||

== Résumé des contenus == | |||

* '''Guides & outils IA''' : assistants, modèles, évaluations, GPU | |||

* '''Cloud & infra''' : HA, HPC, web-scale, DevSecOps | |||

* '''Labs & scripts''' : audit, migration, automation | |||

* '''Tableaux comparatifs''' : Kubernetes vs OpenStack vs AWS vs bare-metal, etc. | |||

---- | |||

= Assistants IA & Outils Cloud = | |||

== Assistants IA == | |||

; '''ChatGPT''' | |||

* [https://chat.openai.com ChatGPT] – Assistant conversationnel public, adapté à l’exploration, à la rédaction et à l’expérimentation rapide. | |||

; '''Assistants IA auto-hébergés''' | |||

* [https://github.com/open-webui/open-webui Open WebUI] + [https://www.scaleway.com/en/h100-pcie-try-it-now/ GPU H100] + [https://ollama.com Ollama] | |||

: Stack type pour assistants privés, LLMs auto-hébergés et API compatibles OpenAI. | |||

* [https://github.com/ynotopec/summarize Private summary] – Résumeur local, rapide et hors-ligne pour vos propres données. | |||

== Développement, modèles & suivi == | |||

; '''Découvrir et suivre les modèles''' | |||

* [https://ollama.com/library LLM Trending] – Bibliothèque de modèles (chat, code, RAG…) pour déploiement local. | |||

* [https://huggingface.co/models Models Trending] – Marketplace de modèles, filtrage par tâche, taille, licence. | |||

* [https://huggingface.co/models?pipeline_tag=image-text-to-text&sort=trending Img2txt Trending] – Modèles vision-langage (image → texte). | |||

* [https://huggingface.co/spaces/TIGER-Lab/GenAI-Arena Txt2img Evaluation] – Comparaison de modèles de génération d’images. | |||

; '''Évaluation & benchmarks''' | |||

* [https://lmarena.ai/leaderboard ChatBot Evaluation] – Classement de chatbots (modèles open-source et propriétaires). | |||

* [https://huggingface.co/spaces/mteb/leaderboard Embedding Leaderboard] – Benchmark des modèles d’embedding pour RAG et recherche sémantique. | |||

* [https://ann-benchmarks.com Vectors DB Ranking] – Comparatif de bases vectorielles (latence, mémoire, fonctionnalités). | |||

* [https://top500.org/lists/green500/ HPC Efficiency] – Classement des supercalculateurs les plus efficaces énergétiquement. | |||

; '''Outils de développement & fine-tuning''' | |||

* [https://github.com/search?q=stars%3A%3E15000+forks%3A%3E1500+created%3A%3E2022-06-01&type=repositories&s=updated&o=desc Project Trending] – Grands projets open source récents, triés par popularité et activité. | |||

* [https://github.com/hiyouga/LLaMA-Factory LLM Fine Tuning] – Framework avancé pour fine-tuning de LLMs (instruction-tuning, LoRA, etc.). | |||

* [https://www.perplexity.ai Perplexity AI] – Recherche avancée et synthèse orientée “copilote de recherche”. | |||

== Matériel IA & GPU == | |||

; '''GPU & accélérateurs''' | |||

* [https://www.nvidia.com/en-us/data-center/h100/ NVIDIA H100] – GPU datacenter pour clusters Kubernetes et workloads IA intensifs. | |||

* NVIDIA 5080 – GPU grand public pour déploiements privés de LLMs à moindre coût. | |||

* [https://www.mouser.fr/ProductDetail/BittWare/RS-GQ-GC1-0109?qs=ST9lo4GX8V2eGrFMeVQmFw%3D%3D GROQ LLM accelerator] – Accélérateur matériel dédié à l’inférence LLM. | |||

---- | |||

= Modèles ouverts & Endpoints internes = | |||

''(Dernière mise à jour : 26/07/2025)'' | |||

Les modèles ci-dessous correspondent à des '''endpoints logiques''' (par exemple via un proxy ou une gateway), choisis pour des usages précis. | |||

{| class="wikitable" | |||

! Endpoint !! Description / Cas d’usage principal | |||

|- | |||

| '''ai-chat''' || Basé sur '''gemma3n''' – Chat généraliste, bon compromis coût / qualité. | |||

|- | |||

| '''ai-translate''' || gemma3n, température = 0 – Traduction déterministe, reproductible (FR, EN, autres langues). | |||

|- | |||

| '''ai-summary''' || qwen2.5 – Modèle optimisé pour la synthèse de textes longs (rapports, docs, transcriptions). | |||

|- | |||

| '''ai-code''' || mistral-small – Raisonnement sur le code, explication et refactorisation. | |||

|- | |||

| '''ai-code-completion''' || granite-2b – Complétion de code rapide, pensée pour l’auto-complétion IDE. | |||

|- | |||

| '''ai-parse''' || gemma2-simpo – Extraction structurée, parsing de logs / JSON / tableaux. | |||

|- | |||

| '''ai-RAG-FR''' || qwen2.5 – Usage RAG en français (connaissance métier, FAQ internes). | |||

|- | |||

| '''mannix/gemma2-9b-simpo''' || Intégration avec '''OllamaFunctions''' (outils, API, automation). | |||

|} | |||

Idée d’usage : chaque endpoint est associé à un ou plusieurs labs (chat, résumé, parsing, RAG, etc.) dans la section Cloud Lab. | |||

---- | |||

= Actualités & Tendances = | |||

* [https://www.youtube.com/@lev-selector/videos Top AI News] – Sélection vidéo des actus IA. | |||

* [https://betterprogramming.pub/color-your-captions-streamlining-live-transcriptions-with-diart-and-openais-whisper-6203350234ef Real-time transcription with Diart + Whisper] – Exemple de transcription temps réel avec détection de locuteurs. | |||

* [https://github.com/openai-translator/openai-translator OpenAI Translator] – Extension / client moderne pour traduction assistée par LLM. | |||

* [https://opensearch.org/docs/latest/search-plugins/conversational-search Opensearch with LLM] – Recherche conversationnelle basée sur LLMs et OpenSearch. | |||

---- | |||

= Formation & Apprentissage = | |||

* [https://www.youtube.com/watch?v=4Bdc55j80l8 Transformers Explained] – Introduction aux Transformers, architecture clé des LLMs. | |||

* Labs, scripts et retours d’expérience concrets dans le projet [[LAB project|CLOUD LAB]] ci-dessous. | |||

---- | |||

= Cloud Lab & Projets d’Audit = | |||

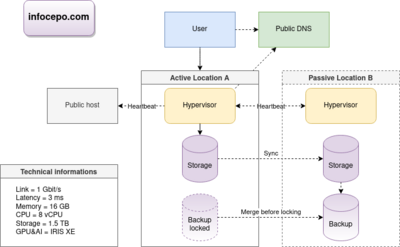

[[File:Infocepo.drawio.png|400px|Diagramme de référence Cloud Lab]] | |||

Le '''Cloud Lab''' propose des scénarios reproductibles : audit d’infrastructure, migration vers le cloud, automatisation, haute disponibilité. | |||

== Projet d’audit – Cloud Audit == | |||

; '''[[ServerDiff.sh]]''' | |||

Script Bash d’audit de serveurs pour : | |||

* détecter les dérives de configuration, | |||

* comparer plusieurs environnements, | |||

* préparer une migration ou un plan de remédiation. | |||

== Exemple de migration Cloud == | |||

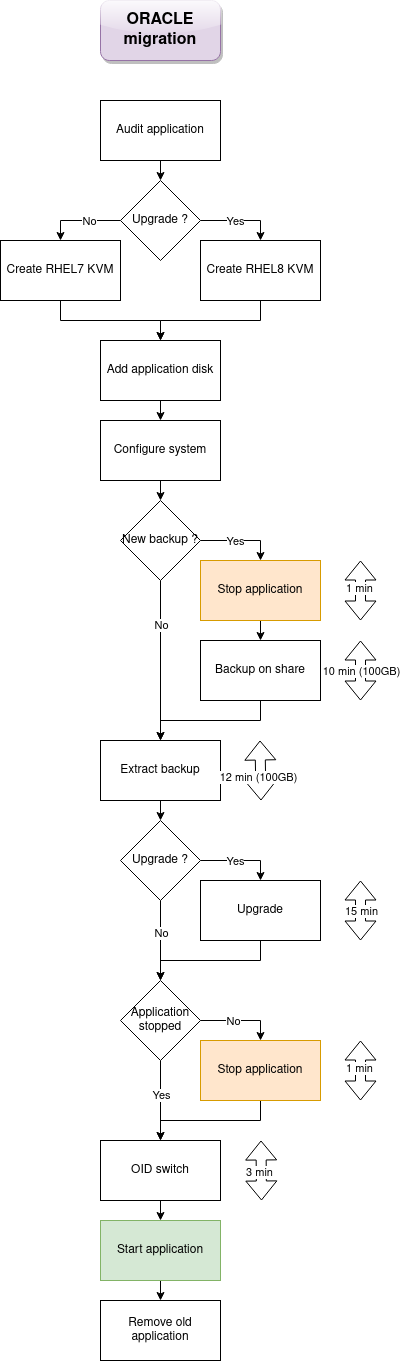

[[File:Diagram-migration-ORACLE-KVM-v2.drawio.png|400px|Diagramme de migration Cloud]] | |||

Exemple : migration d’environnements virtuels vers un cloud modernisé, avec audit, design d’architecture et automatisation. | |||

{| class="wikitable" | |||

! Tâche !! Description !! Durée (jours) | |||

|- | |||

| Audit de l’infrastructure || 82 services, audit automatisé via '''ServerDiff.sh''' || 1,5 | |||

|- | |||

| Diagramme d’architecture cloud || Conception et documentation visuelle || 1,5 | |||

|- | |||

| Contrôle de conformité || 2 clouds, 6 hyperviseurs, 6 To de RAM || 1,5 | |||

|- | |||

| Installation des plateformes cloud || Déploiement des environnements cibles principaux || 1,0 | |||

|- | |||

| Vérification de stabilité || Tests de fonctionnement précoce || 0,5 | |||

|- | |||

| Étude d’automatisation || Identification et automatisation des tâches répétitives || 1,5 | |||

|- | |||

| Développement de templates || 6 templates, 8 environnements, 2 clouds / OS || 1,5 | |||

|- | |||

| Diagramme de migration || Illustration du processus de migration || 1,0 | |||

|- | |||

| Écriture du code de migration || 138 lignes (voir '''MigrationApp.sh''') || 1,5 | |||

|- | |||

| Stabilisation du process || Validation que la migration est reproductible || 1,5 | |||

|- | |||

| Benchmarking cloud || Comparaison de performance vs infrastructure legacy || 1,5 | |||

|- | |||

| Calage du downtime || Calcul du temps de coupure par migration || 0,5 | |||

|- | |||

| Chargement des VMs || 82 VMs : OS, code, 2 IP par VM || 0,1 | |||

|- | |||

! colspan=2 align="right"| '''Total''' !! 15 jours·homme | |||

|} | |||

=== Vérification de stabilité (HA minimale) === | |||

{| class="wikitable" | |||

! Action !! Résultat attendu | |||

|- | |||

| Extinction d’un nœud || Tous les services doivent redémarrer automatiquement sur les nœuds restants. | |||

|- | |||

| Extinction / rallumage simultané de tous les nœuds || Tous les services doivent remonter correctement après redémarrage. | |||

|} | |||

---- | |||

= Architecture Web & Bonnes Pratiques = | |||

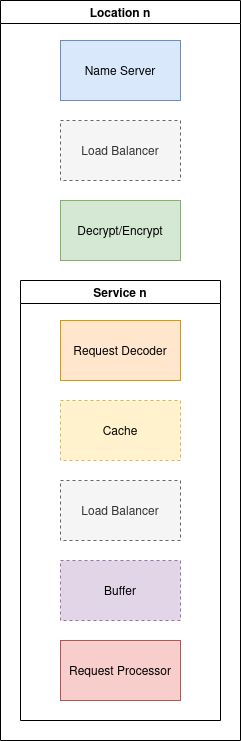

[[File:WebModelDiagram.drawio.png|400px|Architecture Web de référence]] | |||

Principes pour concevoir des architectures web scalables et portables : | |||

* Favoriser une infrastructure '''simple, modulaire et flexible'''. | |||

* Suivre la localisation des clients (GDNS ou équivalent) pour rapprocher les contenus. | |||

* Utiliser des load balancers réseau (LVS, IPVS) pour la montée en charge. | |||

* Comparer systématiquement les coûts, et se méfier du '''vendor lock-in'''. | |||

* TLS : | |||

** HAProxy pour les frontends rapides, | |||

** Envoy pour la compatibilité et les cas avancés (mTLS, HTTP/2/3). | |||

* Cache : | |||

** Varnish, Apache Traffic Server pour les gros volumes de contenu. | |||

* Privilégier les stacks open source et les caches de base de données (ex. Memcached). | |||

* Utiliser des files de messages, buffers et quotas pour lisser les pics de charge. | |||

* Pour des architectures complètes : | |||

** [https://wikitech.wikimedia.org/wiki/Wikimedia_infrastructure Wikimedia Cloud Architecture] | |||

** [https://github.com/systemdesign42/system-design System Design GitHub] | |||

---- | |||

= Comparatif des grandes plateformes Cloud = | |||

{| class="wikitable" | |||

! Fonction !! Kubernetes !! OpenStack !! AWS !! Bare-metal !! HPC !! CRM !! oVirt | |||

|- | |||

| '''Outils de déploiement''' || Helm, YAML, ArgoCD, Juju || Ansible, Terraform, Juju || CloudFormation, Terraform, Juju || Ansible, Shell || xCAT, Clush || Ansible, Shell || Ansible, Python | |||

|- | |||

| '''Méthode de bootstrap''' || API || API, PXE || API || PXE, IPMI || PXE, IPMI || PXE, IPMI || PXE, API | |||

|- | |||

| '''Contrôle des routeurs''' || Kube-router || API Routeur/Sous-réseau || Route Table / Subnet API || Linux, OVS || xCAT || Linux || API | |||

|- | |||

| '''Contrôle du pare-feu''' || Istio, NetworkPolicy || Security Groups API || Security Group API || Pare-feu Linux || Pare-feu Linux || Pare-feu Linux || API | |||

|- | |||

| '''Virtualisation réseau''' || VLAN, VxLAN, autres || VPC || VPC || OVS, Linux || xCAT || Linux || API | |||

|- | |||

| '''DNS''' || CoreDNS || DNS-Nameserver || Route 53 || GDNS || xCAT || Linux || API | |||

|- | |||

| '''Load Balancer''' || Kube-proxy, LVS || LVS || Network Load Balancer || LVS || SLURM || Ldirectord || N/A | |||

|- | |||

| '''Options de stockage''' || Local, Cloud, PVC || Swift, Cinder, Nova || S3, EFS, EBS, FSx || Swift, XFS, EXT4, RAID10 || GPFS || SAN || NFS, SAN | |||

|} | |||

Ce tableau sert de point de départ pour choisir la bonne pile selon : | |||

* Niveau de contrôle souhaité (API vs bare-metal), | |||

* Contexte (on-prem, cloud public, HPC, CRM…), | |||

* Outillage d’automatisation déjà en place. | |||

---- | |||

= Liens utiles Cloud & IT = | |||

* [https://cloud.google.com/free/docs/aws-azure-gcp-service-comparison Cloud Providers Compared] – Correspondance des services AWS / Azure / GCP. | |||

* [https://global-internet-map-2021.telegeography.com/ Global Internet Topology Map] – Cartographie globale de l’Internet. | |||

* [https://landscape.cncf.io/?fullscreen=yes CNCF Official Landscape] – Panorama des projets cloud-native (CNCF). | |||

* [https://wikitech.wikimedia.org/wiki/Wikimedia_infrastructure Wikimedia Cloud Wiki] – Infrastructure Wikimedia, exemple réel à grande échelle. | |||

* [https://openapm.io OpenAPM – SRE Tools] – Outillage APM / observabilité. | |||

* [https://access.redhat.com/downloads/content/package-browser RedHat Package Browser] – Recherche de paquets et versions chez Red Hat. | |||

* [https://www.silkhom.com/barometre-2021-des-tjm-dans-informatique-digital Baromètre TJM Freelance IT] – Référentiel de tarifs freelances. | |||

* [https://www.glassdoor.fr/salaire/Hays-Salaires-E10166.htm IT Salaries (Glassdoor)] – Indications de salaires IT. | |||

---- | |||

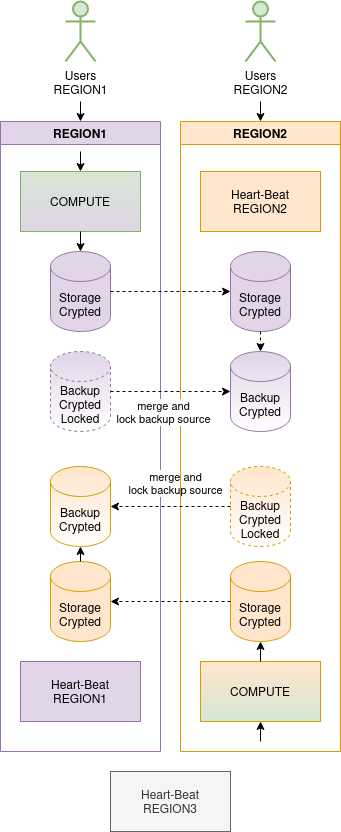

= Avancé : Haute Disponibilité, HPC & DevSecOps = | |||

== Haute Disponibilité avec Corosync & Pacemaker == | |||

[[File:HA-REF.drawio.png|400px|Architecture de cluster HA]] | |||

Principes de base : | |||

* Clusters multi-nœuds ou bi-sites pour la redondance. | |||

* Utilisation d’IPMI pour le fencing, provisioning via PXE/NTP/DNS/TFTP. | |||

* Pour un cluster 2 nœuds : | |||

– séquencer le fencing pour éviter les split-brains, | |||

– 3 nœuds ou plus restent recommandés pour la production. | |||

=== Pattern de ressources courant === | |||

* Stockage multipath, LUN, LVM, NFS. | |||

* Ressources utilisateurs et processus applicatifs. | |||

* IP virtuelle, enregistrements DNS, listeners réseau. | |||

== HPC == | |||

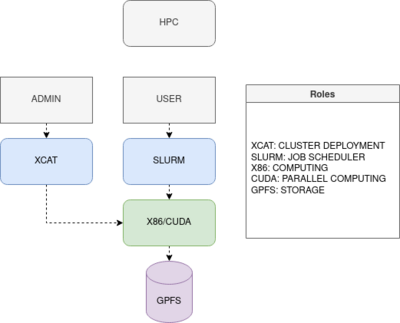

[[File:HPC.drawio.png|400px|Vue d’ensemble d’un cluster HPC]] | |||

* Orchestration de jobs (SLURM ou équivalent). | |||

* Partage de stockage haute performance (GPFS, Lustre…). | |||

* Intégration possible avec des workloads IA (entraînement massif, inference sur GPU). | |||

== DevSecOps == | |||

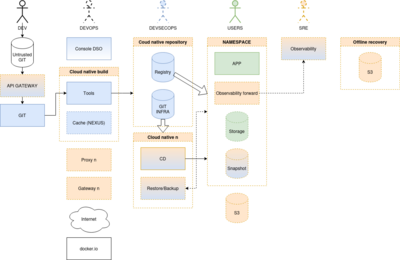

[[File:DSO-POC-V3.drawio.png|400px|Design de référence DevSecOps]] | |||

* Pipelines CI/CD avec contrôles de sécurité intégrés (linting, SAST, DAST, SBOM). | |||

* Observabilité (logs, metrics, traces) intégrée dès la conception. | |||

* Automatisation des scans de vulnérabilités, gestion des secrets, policy-as-code. | |||

---- | |||

= À propos & Contributions = | |||

Pour plus d’exemples, de scripts, de diagrammes et de retours d’expérience, consulter : | |||

* [https://infocepo.com infocepo.com] | |||

Les suggestions de correction, d’amélioration de diagrammes, ou de nouveaux labs sont les bienvenues. | |||

Ce wiki a vocation à rester un '''laboratoire vivant''' pour l’IA, le cloud et l’automatisation. | |||

Latest revision as of 15:13, 24 November 2025

infocepo.com – Cloud, IA & Labs

Bienvenue sur le portail infocepo.com.

Ce wiki s’adresse aux administrateurs système, ingénieurs cloud, développeurs, étudiants et passionnés qui veulent :

- Comprendre les architectures modernes (Kubernetes, OpenStack, bare-metal, HPC…)

- Mettre en place des assistants IA privés et des outils de productivité

- Construire des labs concrets pour apprendre en pratiquant

- Préparer des audits, migrations et automatisations à grande échelle

L’objectif : transformer la théorie en scripts, diagrammes et architectures réutilisables.

Démarrer rapidement

Parcours recommandés

- 1. Monter un assistant IA privé

- Déployer un stack type : Open WebUI + Ollama + GPU (H100 ou GPU grand public)

- Ajouter un modèle de chat + un modèle de résumé

- Intégrer des données internes (RAG, embeddings)

- 2. Lancer un lab Cloud

- Créer un petit cluster (Kubernetes, OpenStack ou bare-metal)

- Mettre en place un pipeline de déploiement (Helm, Ansible, Terraform…)

- Ajouter un service IA (transcription, résumé, chatbot…)

- 3. Préparer un audit/migration

- Inventorier les serveurs avec ServerDiff.sh

- Dessiner l’architecture cible (diagrammes cloud)

- Automatiser la migration avec des scripts reproductibles

Résumé des contenus

- Guides & outils IA : assistants, modèles, évaluations, GPU

- Cloud & infra : HA, HPC, web-scale, DevSecOps

- Labs & scripts : audit, migration, automation

- Tableaux comparatifs : Kubernetes vs OpenStack vs AWS vs bare-metal, etc.

Assistants IA & Outils Cloud

Assistants IA

- ChatGPT

- ChatGPT – Assistant conversationnel public, adapté à l’exploration, à la rédaction et à l’expérimentation rapide.

- Assistants IA auto-hébergés

- Open WebUI + GPU H100 + Ollama

- Stack type pour assistants privés, LLMs auto-hébergés et API compatibles OpenAI.

- Private summary – Résumeur local, rapide et hors-ligne pour vos propres données.

Développement, modèles & suivi

- Découvrir et suivre les modèles

- LLM Trending – Bibliothèque de modèles (chat, code, RAG…) pour déploiement local.

- Models Trending – Marketplace de modèles, filtrage par tâche, taille, licence.

- Img2txt Trending – Modèles vision-langage (image → texte).

- Txt2img Evaluation – Comparaison de modèles de génération d’images.

- Évaluation & benchmarks

- ChatBot Evaluation – Classement de chatbots (modèles open-source et propriétaires).

- Embedding Leaderboard – Benchmark des modèles d’embedding pour RAG et recherche sémantique.

- Vectors DB Ranking – Comparatif de bases vectorielles (latence, mémoire, fonctionnalités).

- HPC Efficiency – Classement des supercalculateurs les plus efficaces énergétiquement.

- Outils de développement & fine-tuning

- Project Trending – Grands projets open source récents, triés par popularité et activité.

- LLM Fine Tuning – Framework avancé pour fine-tuning de LLMs (instruction-tuning, LoRA, etc.).

- Perplexity AI – Recherche avancée et synthèse orientée “copilote de recherche”.

Matériel IA & GPU

- GPU & accélérateurs

- NVIDIA H100 – GPU datacenter pour clusters Kubernetes et workloads IA intensifs.

- NVIDIA 5080 – GPU grand public pour déploiements privés de LLMs à moindre coût.

- GROQ LLM accelerator – Accélérateur matériel dédié à l’inférence LLM.

Modèles ouverts & Endpoints internes

(Dernière mise à jour : 26/07/2025)

Les modèles ci-dessous correspondent à des endpoints logiques (par exemple via un proxy ou une gateway), choisis pour des usages précis.

| Endpoint | Description / Cas d’usage principal |

|---|---|

| ai-chat | Basé sur gemma3n – Chat généraliste, bon compromis coût / qualité. |

| ai-translate | gemma3n, température = 0 – Traduction déterministe, reproductible (FR, EN, autres langues). |

| ai-summary | qwen2.5 – Modèle optimisé pour la synthèse de textes longs (rapports, docs, transcriptions). |

| ai-code | mistral-small – Raisonnement sur le code, explication et refactorisation. |

| ai-code-completion | granite-2b – Complétion de code rapide, pensée pour l’auto-complétion IDE. |

| ai-parse | gemma2-simpo – Extraction structurée, parsing de logs / JSON / tableaux. |

| ai-RAG-FR | qwen2.5 – Usage RAG en français (connaissance métier, FAQ internes). |

| mannix/gemma2-9b-simpo | Intégration avec OllamaFunctions (outils, API, automation). |

Idée d’usage : chaque endpoint est associé à un ou plusieurs labs (chat, résumé, parsing, RAG, etc.) dans la section Cloud Lab.

Actualités & Tendances

- Top AI News – Sélection vidéo des actus IA.

- Real-time transcription with Diart + Whisper – Exemple de transcription temps réel avec détection de locuteurs.

- OpenAI Translator – Extension / client moderne pour traduction assistée par LLM.

- Opensearch with LLM – Recherche conversationnelle basée sur LLMs et OpenSearch.

Formation & Apprentissage

- Transformers Explained – Introduction aux Transformers, architecture clé des LLMs.

- Labs, scripts et retours d’expérience concrets dans le projet CLOUD LAB ci-dessous.

Cloud Lab & Projets d’Audit

Le Cloud Lab propose des scénarios reproductibles : audit d’infrastructure, migration vers le cloud, automatisation, haute disponibilité.

Projet d’audit – Cloud Audit

Script Bash d’audit de serveurs pour :

- détecter les dérives de configuration,

- comparer plusieurs environnements,

- préparer une migration ou un plan de remédiation.

Exemple de migration Cloud

Exemple : migration d’environnements virtuels vers un cloud modernisé, avec audit, design d’architecture et automatisation.

| Tâche | Description | Durée (jours) |

|---|---|---|

| Audit de l’infrastructure | 82 services, audit automatisé via ServerDiff.sh | 1,5 |

| Diagramme d’architecture cloud | Conception et documentation visuelle | 1,5 |

| Contrôle de conformité | 2 clouds, 6 hyperviseurs, 6 To de RAM | 1,5 |

| Installation des plateformes cloud | Déploiement des environnements cibles principaux | 1,0 |

| Vérification de stabilité | Tests de fonctionnement précoce | 0,5 |

| Étude d’automatisation | Identification et automatisation des tâches répétitives | 1,5 |

| Développement de templates | 6 templates, 8 environnements, 2 clouds / OS | 1,5 |

| Diagramme de migration | Illustration du processus de migration | 1,0 |

| Écriture du code de migration | 138 lignes (voir MigrationApp.sh) | 1,5 |

| Stabilisation du process | Validation que la migration est reproductible | 1,5 |

| Benchmarking cloud | Comparaison de performance vs infrastructure legacy | 1,5 |

| Calage du downtime | Calcul du temps de coupure par migration | 0,5 |

| Chargement des VMs | 82 VMs : OS, code, 2 IP par VM | 0,1 |

| Total | 15 jours·homme | |

Vérification de stabilité (HA minimale)

| Action | Résultat attendu |

|---|---|

| Extinction d’un nœud | Tous les services doivent redémarrer automatiquement sur les nœuds restants. |

| Extinction / rallumage simultané de tous les nœuds | Tous les services doivent remonter correctement après redémarrage. |

Architecture Web & Bonnes Pratiques

Principes pour concevoir des architectures web scalables et portables :

- Favoriser une infrastructure simple, modulaire et flexible.

- Suivre la localisation des clients (GDNS ou équivalent) pour rapprocher les contenus.

- Utiliser des load balancers réseau (LVS, IPVS) pour la montée en charge.

- Comparer systématiquement les coûts, et se méfier du vendor lock-in.

- TLS :

- HAProxy pour les frontends rapides,

- Envoy pour la compatibilité et les cas avancés (mTLS, HTTP/2/3).

- Cache :

- Varnish, Apache Traffic Server pour les gros volumes de contenu.

- Privilégier les stacks open source et les caches de base de données (ex. Memcached).

- Utiliser des files de messages, buffers et quotas pour lisser les pics de charge.

- Pour des architectures complètes :

Comparatif des grandes plateformes Cloud

| Fonction | Kubernetes | OpenStack | AWS | Bare-metal | HPC | CRM | oVirt |

|---|---|---|---|---|---|---|---|

| Outils de déploiement | Helm, YAML, ArgoCD, Juju | Ansible, Terraform, Juju | CloudFormation, Terraform, Juju | Ansible, Shell | xCAT, Clush | Ansible, Shell | Ansible, Python |

| Méthode de bootstrap | API | API, PXE | API | PXE, IPMI | PXE, IPMI | PXE, IPMI | PXE, API |

| Contrôle des routeurs | Kube-router | API Routeur/Sous-réseau | Route Table / Subnet API | Linux, OVS | xCAT | Linux | API |

| Contrôle du pare-feu | Istio, NetworkPolicy | Security Groups API | Security Group API | Pare-feu Linux | Pare-feu Linux | Pare-feu Linux | API |

| Virtualisation réseau | VLAN, VxLAN, autres | VPC | VPC | OVS, Linux | xCAT | Linux | API |

| DNS | CoreDNS | DNS-Nameserver | Route 53 | GDNS | xCAT | Linux | API |

| Load Balancer | Kube-proxy, LVS | LVS | Network Load Balancer | LVS | SLURM | Ldirectord | N/A |

| Options de stockage | Local, Cloud, PVC | Swift, Cinder, Nova | S3, EFS, EBS, FSx | Swift, XFS, EXT4, RAID10 | GPFS | SAN | NFS, SAN |

Ce tableau sert de point de départ pour choisir la bonne pile selon :

- Niveau de contrôle souhaité (API vs bare-metal),

- Contexte (on-prem, cloud public, HPC, CRM…),

- Outillage d’automatisation déjà en place.

Liens utiles Cloud & IT

- Cloud Providers Compared – Correspondance des services AWS / Azure / GCP.

- Global Internet Topology Map – Cartographie globale de l’Internet.

- CNCF Official Landscape – Panorama des projets cloud-native (CNCF).

- Wikimedia Cloud Wiki – Infrastructure Wikimedia, exemple réel à grande échelle.

- OpenAPM – SRE Tools – Outillage APM / observabilité.

- RedHat Package Browser – Recherche de paquets et versions chez Red Hat.

- Baromètre TJM Freelance IT – Référentiel de tarifs freelances.

- IT Salaries (Glassdoor) – Indications de salaires IT.

Avancé : Haute Disponibilité, HPC & DevSecOps

Haute Disponibilité avec Corosync & Pacemaker

Principes de base :

- Clusters multi-nœuds ou bi-sites pour la redondance.

- Utilisation d’IPMI pour le fencing, provisioning via PXE/NTP/DNS/TFTP.

- Pour un cluster 2 nœuds :

– séquencer le fencing pour éviter les split-brains, – 3 nœuds ou plus restent recommandés pour la production.

Pattern de ressources courant

- Stockage multipath, LUN, LVM, NFS.

- Ressources utilisateurs et processus applicatifs.

- IP virtuelle, enregistrements DNS, listeners réseau.

HPC

- Orchestration de jobs (SLURM ou équivalent).

- Partage de stockage haute performance (GPFS, Lustre…).

- Intégration possible avec des workloads IA (entraînement massif, inference sur GPU).

DevSecOps

- Pipelines CI/CD avec contrôles de sécurité intégrés (linting, SAST, DAST, SBOM).

- Observabilité (logs, metrics, traces) intégrée dès la conception.

- Automatisation des scans de vulnérabilités, gestion des secrets, policy-as-code.

À propos & Contributions

Pour plus d’exemples, de scripts, de diagrammes et de retours d’expérience, consulter :

Les suggestions de correction, d’amélioration de diagrammes, ou de nouveaux labs sont les bienvenues. Ce wiki a vocation à rester un laboratoire vivant pour l’IA, le cloud et l’automatisation.